**افشای استفاده از هوش مصنوعی در عملیات نظامی ایالات متحده**

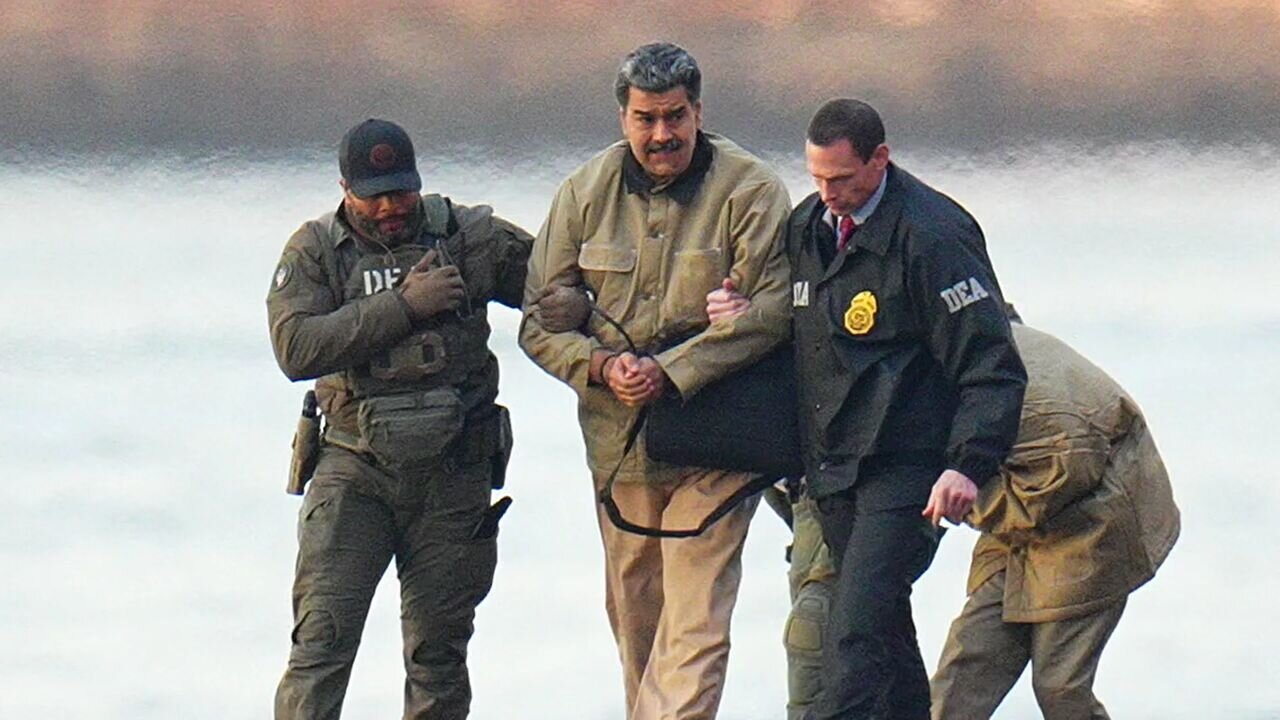

به گزارش خبرآنلاین، در ژانویه ۲۰۲۶، نیروهای ویژه آمریکا عملیاتی را به منظور دستگیری نیکلاس مادورو، رئیسجمهور ونزوئلا، و همسرش اجرا کردند که این اقدام به انتقال آنها به ایالات متحده منجر شد تا با اتهامات مربوط به مواد مخدر روبرو شوند. در تاریخ ۱۳ و ۱۴ فوریه ۲۰۲۶، رسانههایی نظیر وال استریت ژورنال و اکسیوس اعلام کردند که مدل هوش مصنوعی کلاود از شرکت Anthropic ظاهراً در این عملیات مورد استفاده قرار گرفته است. این موضوع منجر به ایجاد بحثهایی در زمینه تلاقی هوش مصنوعی و عملیاتهای نظامی گشته است.

گفتوگویی با یکی از اعضای Anthropic انجام شد تا پیامدهای فنی و اخلاقی این مسئله بررسی شود. در این گفتوگو، به تأیید استفاده از هوش مصنوعی کلاود در عملیات ونزوئلا اشاره نشد. سخنگوی Anthropic تصریح کرد که توانایی اظهارنظر درباره عملیاتهای طبقهبندیشده را ندارد و تأکید کرد که اطلاعاتی از فعالیتهای نظامی ندارند.

همچنین اشاره شد که این مدلها بهطور گسترده از طریق همکاری با شرکتهایی مانند Palantir در دسترس بخشهای نظامی قرار میگیرند. در ادامه، پرسشاتی درباره کارکردهای بالقوه این فناوری در عملیاتهای نظامی مطرح شد. اگر کلاود در چنین عملیاتی استفاده شده باشد، ممکن است در پردازش دادهها، تحلیل اطلاعات و تسهیل تصمیمگیریها نقش داشته باشد.

سخنگوی Anthropic در این زمینه تصریح کرد که در حال حاضر جزئیات دقیق درباره نقش کلاود در این عملیات افشا نشده و شرکت در مذاکراتی با پنتاگون به منظور حفظ محدودیتهای ایمنی خود میباشد.

این در حالی است که کلاود ممکن است به دلیل دسترسی به سیستمهای طبقهبندیشده و تواناییهای فنی خود از سایر مدلهای مشابه متمایز باشد. اما لازم به ذکر است که دیگر شرکتهای هوش مصنوعی نیز قراردادهای مشابهی با پنتاگون دارند.

به طور کلی، این مسائل نشاندهنده چالشهای ناشی از استفاده از فناوریهای پیشرفته در زمینههای نظامی و ریسکهای مرتبط با آن است.### تاثیرات گفتمان علمی و پویاییهای بازار کلاود و ایمنی هوش مصنوعی

تحقیقات اخیر نشان میدهد که تعاملات شرکت Anthropic با پنتاگون، تأثیرات مثبتی و منفی بر بازار کلاود و هوش مصنوعی خواهد داشت.

#### تأثیرات منفی

از جمله نگرانیهای موجود، میتوان به مسئله اعتماد عمومی اشاره کرد. کاربرانی که به دلیل تعهد Anthropic به ایمنی، این شرکت را انتخاب کردهاند، ممکن است با تناقض در ارزشهای خود مواجه شوند. علاوه بر این، مشتریان ممکن است نگران نحوه استفاده از دادههای شخصی خود باشند. همچنین، پنتاگون در حال بررسی امکان لغو قرارداد ۲۰۰ میلیون دلاری با این شرکت به دلیل پرسشهایی است که از سوی Anthropic مطرح شده است.

#### تأثیرات مثبت

از سوی دیگر، این تعاملات میتوانند نشاندهنده قابلیتهای فنی بالا در زمینههای حیاتی باشند. ممکن است این شرکت بتواند مشتریان سازمانی را که به سامانههای قابل اعتماد نیاز دارند، جذب کند. به علاوه، استفاده عملی از این فناوریها در سناریوهای واقعی، موفقیتهای بیشتری را در پی خواهد داشت. این موضوع میتواند موجب بحثهای علمی و اخلاقی جدی شود و سوالات اساسی درباره همسازی ایمنی و همکاری با نظامیان را مطرح کند.

به گزارش ایسنا، این تحلیل بر اساس اطلاعاتی از منابع مختلف منتشرشده در تاریخ ۱۳ و ۱۴ فوریه ۲۰۲۶، از جمله گزارشهای انحصاری وال استریت ژورنال و اکسیوس تنظیم شده است. افزودن به این پوشش خبری، گزارشهای رویترز، فاکس نیوز، یاهو نیوز و آرتی نیز مورد اشاره قرار گرفته است.

جزئیات کلیدی این گزارش شامل استفاده از کلاود در عملیات دستگیری نیکلاس مادورو در ژانویه ۲۰۲۶، همکاری Anthropic با Palantir Technologies، و مذاکرات جاری با پنتاگون در خصوص شرایط استفاده به ارزش ۲۰۰ میلیون دلار میباشد. همچنین سخنگویان Anthropic تأکید کردهاند که در مورد عملیاتهای طبقهبندیشده خاص اظهارنظری نخواهند کرد و تمامی استفادههای کلاود باید مطابق با خطمشیهای این شرکت باشد.

علاوه بر Anthropic، دیگر شرکتهای هوش مصنوعی همچون OpenAI، Google، و xAI نیز قراردادهای مشابهی با پنتاگون دارند، و وزیر دفاع، پیت هگسث، به ترویج ادغام سریع هوش مصنوعی در نیروهای نظامی مشغول است.

این مطلب بر اساس گفتگو با مدل Claude Sonnet 4.5 تنظیم شده است.