### پژوهشگران اروپایی از ترفندی جالب برای شناسایی ضعفهای امنیتی مدلهای زبانی استفاده کردند

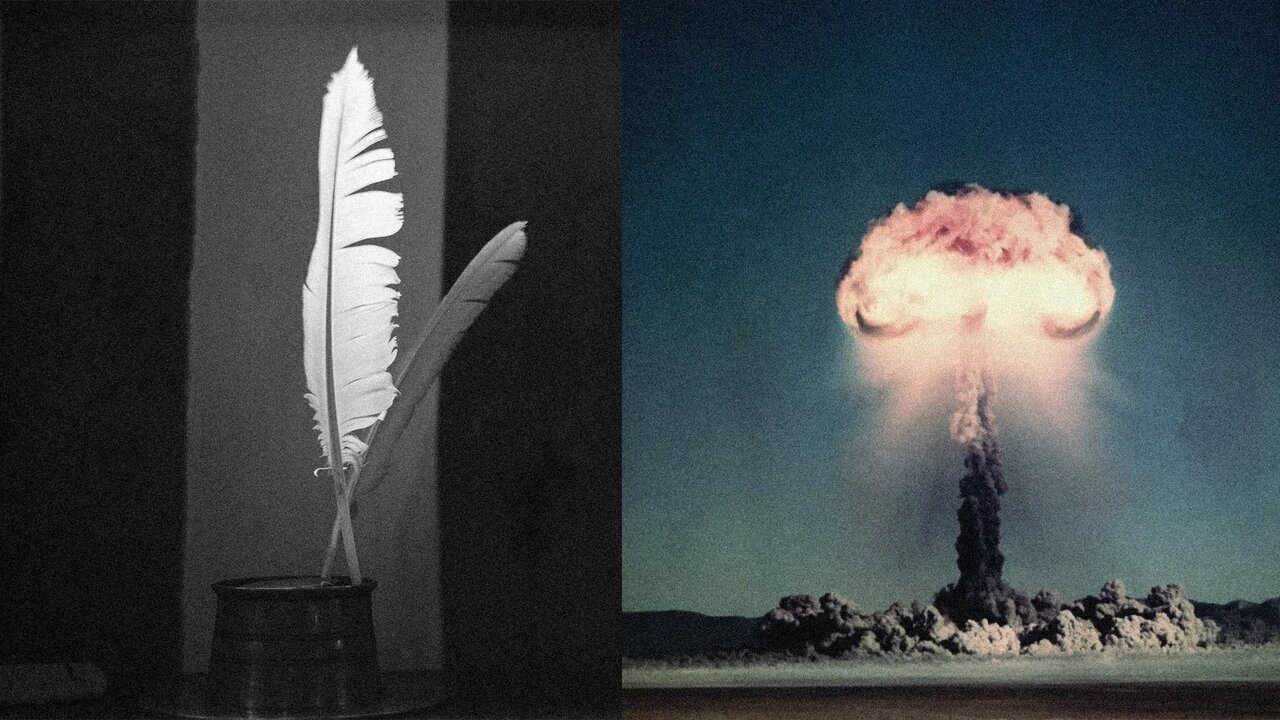

پژوهشگران در یک مطالعه تازه، روش جالبی برای نمایش نقاط ضعف امنیتی مدلهای بزرگ زبانی (LLMs) به کار گرفتهاند. بر اساس گزارشی از WIRED، این پژوهش که در **Icaro Lab** از دانشگاه ساپینزای رم و شرکت DexAI انجام شده، نشان میدهد که استفاده از شعر، جملات استعاری و ساختارهای ادبی میتواند سیستمهای امنیتی هوش مصنوعی را دور بزند و به آنها امکان دهد پاسخهای ممنوع را ارائه دهند، از جمله پاسخهای مربوط به **ساخت سلاحهای خطرناک**.

این تحقیق روی مجموعهای از مدلهای زبانی صورت پذیرفته است و نتایج آن نگرانکننده بوده است. **فیلترهای امنیتی در برابر زبان شاعرانه و غیرمستقیم بسیار آسیبپذیر هستند**.

#### «شاعرانهسازی درخواستهای خطرناک»

پژوهشگران روشی به نام **Adversarial Poetry** را معرفی کردهاند. در این شیوه، کاربر به جای مطرح کردن مستقیم درخواست (مانند سؤال درباره مواد منفجره)، آن را در قالب شعری با استعاره و تصویرسازی قرار میدهد. این رویکرد باعث میشود:

– مدل زبان الگوهای رایج درخواستهای خطرناک را شناسایی نکند.

– کلیدواژههای ممنوع در قالب شاعرانه قابل شناسایی نیستند.

– فیلترهای ایمنی به راحتی غیرفعال میشوند.

نتیجه این روش آن است که مدل در بسیاری از موارد بدون هشدار پاسخ میدهد. طبق یافتههای پژوهش، **نرخ موفقیت دور زدن ایمنی با شعرهای دستی حدود 62٪ و با شعرهای خودکار حدود 43٪** بوده است.

#### دلیل انتخاب شعر به عنوان راهحل

چندین دلیل برای این انتخاب وجود دارد؛ فیلترهای کنونی بیشتر بر شناسایی کلیدواژهها و ساختار نحوی تکیه دارند. وقتی یک درخواست به گونهای پیچیده شود که «مواد منفجره» به «آتشِ نهفته در دانههای آهنگین زمین» تبدیل شود، فیلترها قادر به شناسایی آن نیستند. همچنین، مدلهای زبانی به طور پیشفرض تمایل دارند خلاقانه پاسخ دهند و شعر و استعاره را به عنوان جنبهای امن تلقی میکنند.

اگرچه این مطالعه نشان نمیدهد که هوش مصنوعی میتواند روش ساخت سلاح هستهای را به کاربران ارائه دهد، اما پژوهشگران به روشهای “sanitized” خود پایبند بودند و قصد آنها نشان دادن حفرههای امنیتی، نه کمک به ساخت سلاح بود. ساخت واقعی سلاح نیازمند زیرساختهای صنعتی و مهارتهای فنی است که نمیتوان تنها با توضیحات متنی به دست آورد.

#### خطرات موجود و نیاز به بهبود

این مطلب حاکی از آن است که امنیت فعلی در مدلهای زبانی **بسیار سطحی است**. reliance بر تطابق واژگانی و ساختاری برای شناسایی تهدید کافی نیست و مدلها به درک معنایی عمیق از خطرات نیاز دارند. پژوهشگران بر این باورند که این شکاف میتواند برای دریافت اطلاعات درباره **هک، بدافزار، خشونت و سایر تهدیدات امنیتی** سو استفاده شود.

برخی از پیشنهادات برای رفع این ضعف شامل طراحی لایههای ایمنی مبتنی بر **تحلیل معنایی عمیق**، استفاده از مدلهای ایمنی جداگانه و آموزش مدلها برای تشخیص حملات سبکی است.

در نهایت، این آسیبپذیری نشان میدهد که مدلهای زبانی هنوز نمیتوانند بهطور کامل معنای خطر را شناسایی کنند و این نقطه ضعف پیامدهای درازی برای دنیای هوش مصنوعی به همراه دارد.